こんにちは、AROUSAL Tech.広報部です。

突然ですが皆さん、生成AIが身近になった今、「ChatGPT※があればなんでもできる!」と思っていませんか?

画像生成、議事録作成、料理メニュー、運動計画…

ChatGPTの登場以降、私たちの仕事や生活にAIがどんどん入り込んできました。とても便利な反面、「え、この答えは間違っているんじゃない・・・?」というような失敗も意外と多いんです。

実は、ChatGPTには「苦手なこと」がはっきりと存在します。

今回は、ChatGPTに“うっかり頼むと危ない”5つのパターンと、その対策をわかりやすく紹介します。

それではさっそく見ていきましょう。

※本記事におけるChatGPTは最も一般的な4oモデルを指します。

① むずかしい計算やややこしい数式は苦手

ChatGPTは「おしゃべりが得意なロボット」であって、「計算機」ではありません。

失敗例:

- 表の中の数字を見て「平均を出して」と頼んだら、合ってるようでよく見ると間違い。

- 数学の問題を解かせたら、途中の式はそれっぽいのに結論がズレてる。

実際に、ChatGPTに「8053かける6894を教えて下さい」と命令すると、以下のような結果に。

答えは「55,475,382」であると返答してきましたが、正しくは「55,517,382」です。

この他にも、数値を使った比較をお願いしたら、出てきた割合が現実と全然違ってビックリしたことがあります。

そのため、ChatGPTには極力計算を行わせない方がよいですね。

対策:

- 計算方法だけ考えてもらい、計算自体は自分でする。

- 複雑なものはスプレッドシートや電卓でダブルチェック。

- ChatGPTに計算させるときは「途中の計算も全部見せて」と頼むのがポイントです。

② ステップが多い思考や推理には弱い

ChatGPTは「予想して文章を出す仕組み」なので、深く考えを進めるのは苦手です。

- 失敗の例:

「この人がこう言ったのはなぜ?」→分析が浅くて納得できない。 - 「5年後のトレンドは?」→それっぽく言ってるけど根拠が弱い。

「なるほど…って思ったけど、よく読んだら“それっぽいだけ”じゃん!」と感じたこと、ありませんか?

対策:

- 話をいきなり丸投げせず、ステップに分けて質問する。

- 例:「まず背景をまとめて」「次に選択肢を出して」など段階を分けて聞くと精度が上がります。

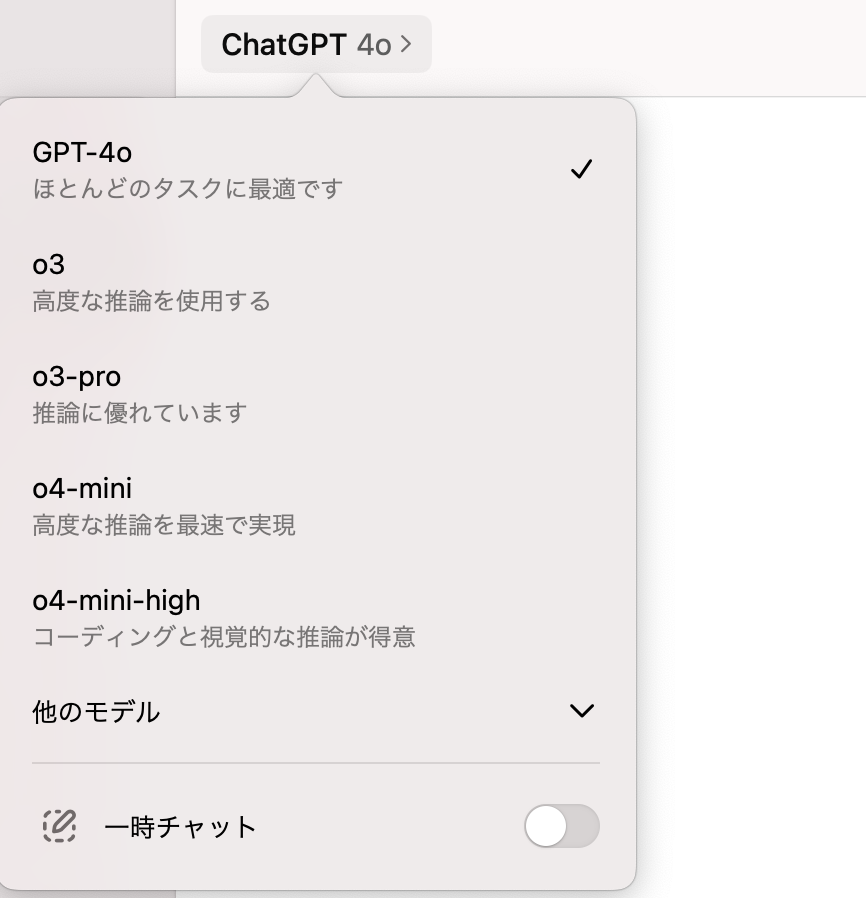

- 最も一般的なo4モデルではなく、推論に強い3oや3o-proモデルを使用する

特に、最近では3oや3o-proなど推論力が大幅に向上したモデルが公開されているため、そちらを利用してみるとよいでしょう。

モデルの変更は、ChatGPTのチャット画面の左上から選択可能です。

③正確な事実を聞くと、あやしいことも…

ChatGPTは、世の中のいろんな文章をもとに学習していますが、全部の本やサイトを覚えているというわけではないのに加えて、リアルタイムでネット検索もできません(※DeepResearchや検索機能がついている場合は別)。

そのため、「それってほんと?」と聞かれると、それっぽく見えるウソを言ってくることがあります。

この、ChatGPTが嘘をつく現象のことを、一般的に「ハルシネーション」と呼びます。

失敗例:

- 「この本の3章には何が書いてある?」→読んだことないのに答える

- ・「この人の名言と出典を教えて」→存在しない名言を勝手に作ることがある

実際に、私も広報業務において「〇〇というAIツールの活用事例を教えて」と命令してみたところ、とてもよい事例を教えてくれた!と思ったらネットで調べても一切出てこなかったということがありました。

対策:

- 正確な事実が知りたい場合には、検索に強いツールを使用。(Felo、Perplexityなど)

- Grokのファクトチェック機能を活用

- 利用するツールをChatGPTで統一したい場合には、「DeepResearch機能」や「検索機能」を活用

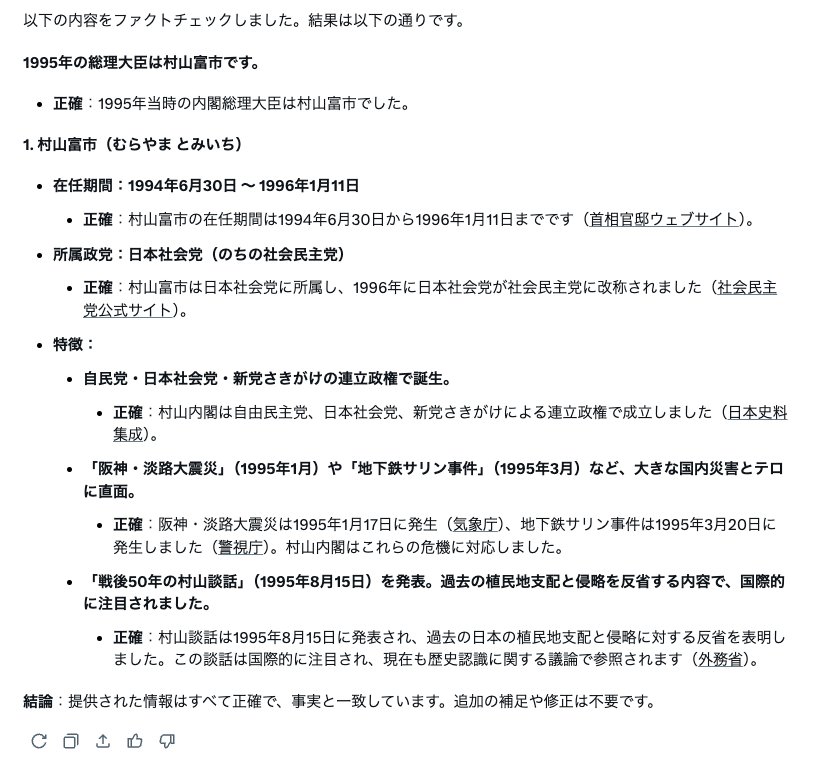

特にGrokのファクトチェック機能は、文章を細分化してセクションごとに正確かどうかを教えてくれるため、正確性を重視する資料を作成する際など私もよく利用しています。

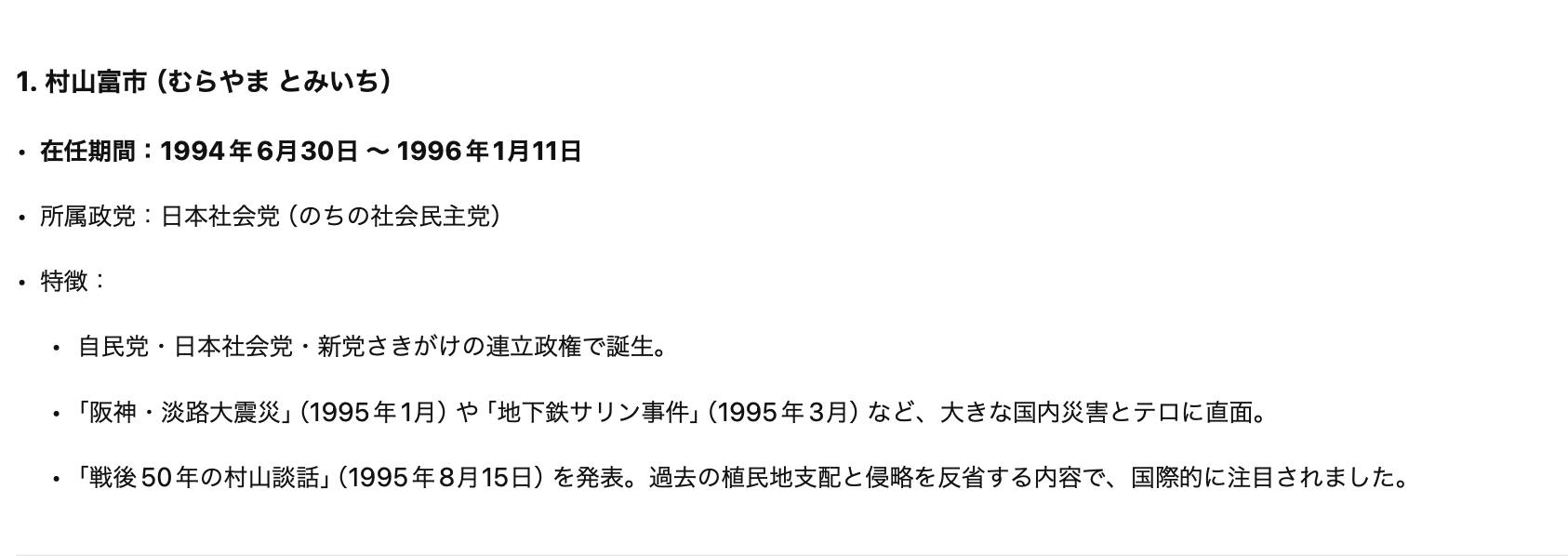

例えば、ChatGPTに「1995年の総理大臣は誰?」と質問したところ、以下のように返答がありました。

これを、Grokに合っているかどうかファクトチェックするように依頼してみます。

プロンプトは、「以下をファクトチェックして」と入力し、その下に先ほどChatGPTで出力された回答をペーストすればOKです。

そうすると、以下の通り細部まで細かく正確かどうかをチェックしてくれました。

このように、複数のツールを組み合わせて活用することでさらにChatGPTの出力を正確かつ効果的に活用することができます。

④ プログラムを“動かす”のはできない

ChatGPTはコードを“書く”のは得意。でも、自分でそのコードを“動かす”ことはできません。

失敗の例:

- 「このコードでエラーが出るんだけど…」→それっぽい修正を出すが実行は不可。

- 「結果を出して」と頼んでも、動作確認はできない。

つまり、ChatGPTは“先生”のような存在で、やり方は教えてくれるけど、代わりに実行してくれるわけではありません。

対策:

- 環境やエラー内容をしっかり伝えて、具体的に質問する。

- 「このコードを●●環境で実行したらエラーが出た」など、詳細を書くと改善案が精度UP

⑤人の気持ち・感情の“深読み”はズレることがある

LINEの文章を見て「相手、怒ってる?」みたいな判断、人間でも難しいですよね。

ChatGPTは言葉からある程度の感情は読み取れますが、「関係性」や「その人の性格」「過去の経緯」まではわかりません。

失敗の例:

- 軽い冗談を「怒っている」と読み間違う。

- やさしい言葉を「落ち込んでる?」と解釈してしまう。

対策:

- 感情分析は“参考意見”として見る。

- 「この言い方ってどういうトーン?」と補足的に使うのが正解です。

また、私もよくする活用法なのですが、先にChatGPTに感情のニュアンスを伝えることは有効です。

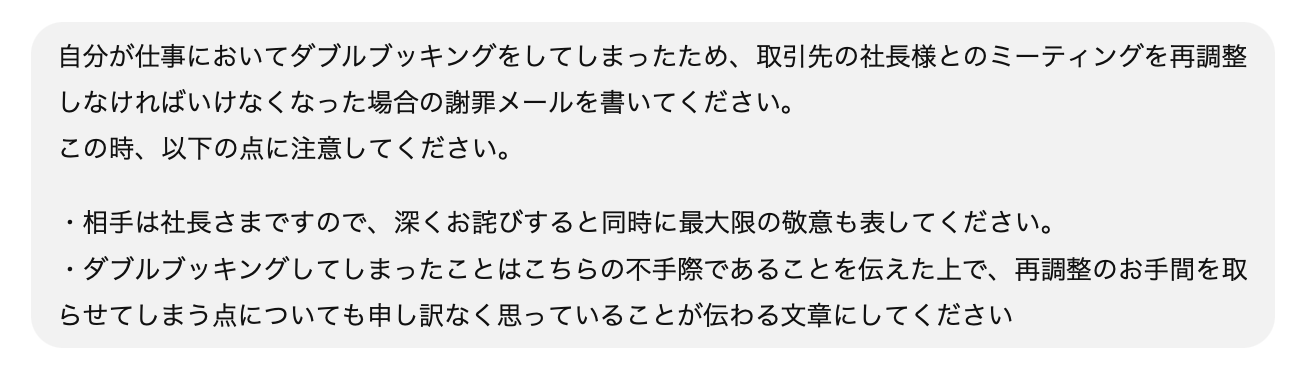

例えば、自分が仕事においてダブルブッキングをしてしまったため、取引先の社長様とのミーティングを再調整しなければいけなくなった場合の謝罪メールをChatGPTに書かせてみましょう。

このように、先にChatGPTに感情をインストールした上で、それを反映したメッセージを書かせてみます。

すると、以下のように出力されました。

このように、事前に伝えておいたニュアンスをしっかりと反映したメールを作成してくれます。

一から文章を考えるよりも、ニュアンスや表現という点ではChatGPTにまずたたき台を作ってもらう方が安心な場合もあります。

このように、ChatGPTは「感情を読み取る」ことは苦手でも、「感情を込めた文章を作成する」ことは得意なので、頼り方を少し工夫してみるのも手ですね。

まとめ:AIに任せる/任せないの“見極め”が大切!

| 頼ってOKなこと | 気をつけたほうがいいこと |

| ざっくりとしたアイデア出し | 精密な計算や統計処理 |

| 短い要約や箇条書きの作成 | 複雑な論理展開 |

| 初歩的なコード例 | 本番環境で動かすプログラム |

| 感情トーンの傾向 | 相手の本音・空気の深読み |

| 概要レベルの事実 | 引用・出典が必要な情報 |

いかがでしたか?

万能に見えて、ついつい頼りすぎてしまうChatGPT。

何でもかんでもさせてしまうと、取り返しのつかない事態に発展することもあります。

ChatGPTはあくまで「サポート役」として活用してみてくださいね。

正しく使いこなせば、あなたの仕事も生活もぐっと効率的になります。

おまけ:今日から使える“頼み方のコツ”3選

- **「手順をステップごとに教えて」**と細かく頼む

- 「間違いがあったら教えて」と逆にチェック役にする

- 「あなたの答えの根拠は?」と理由まで聞く

これらの裏技プロンプトもぜひつかってみてくださいね!

あなたもChatGPTと“ちょうどいい距離感”を見つけよう!

今後、AIはますます私たちの暮らしの中に浸透していきます。

だからこそ、失敗しないための“使いこなし術”を身につけておくことが大切です。

この先、もっと便利に、もっと安心して使うために──

まずは「AIに丸投げしすぎない」ことからはじめてみませんか?