| この記事でわかること |

|

| この記事の対象者 |

|

| 効率化できる業務 |

|

「この市場データ、本当に正確?」「このレポート、AIが作ったんだけど、なんだか自信満々に間違ったことを言ってる気がする…」

企業のDX推進や日々の業務で生成AIを使い始めたあなたも、一度はこんな風に感じたことがあるかもしれません。AIがもっともらしい顔で、平然と事実と異なる情報を生成する現象――「ハルシネーション(幻覚)」。

この厄介な問題は、AI活用の大きな壁として、多くのビジネスパーソンを悩ませてきました。しかし、その根本的な原因の謎が、ついに解き明かされようとしています。

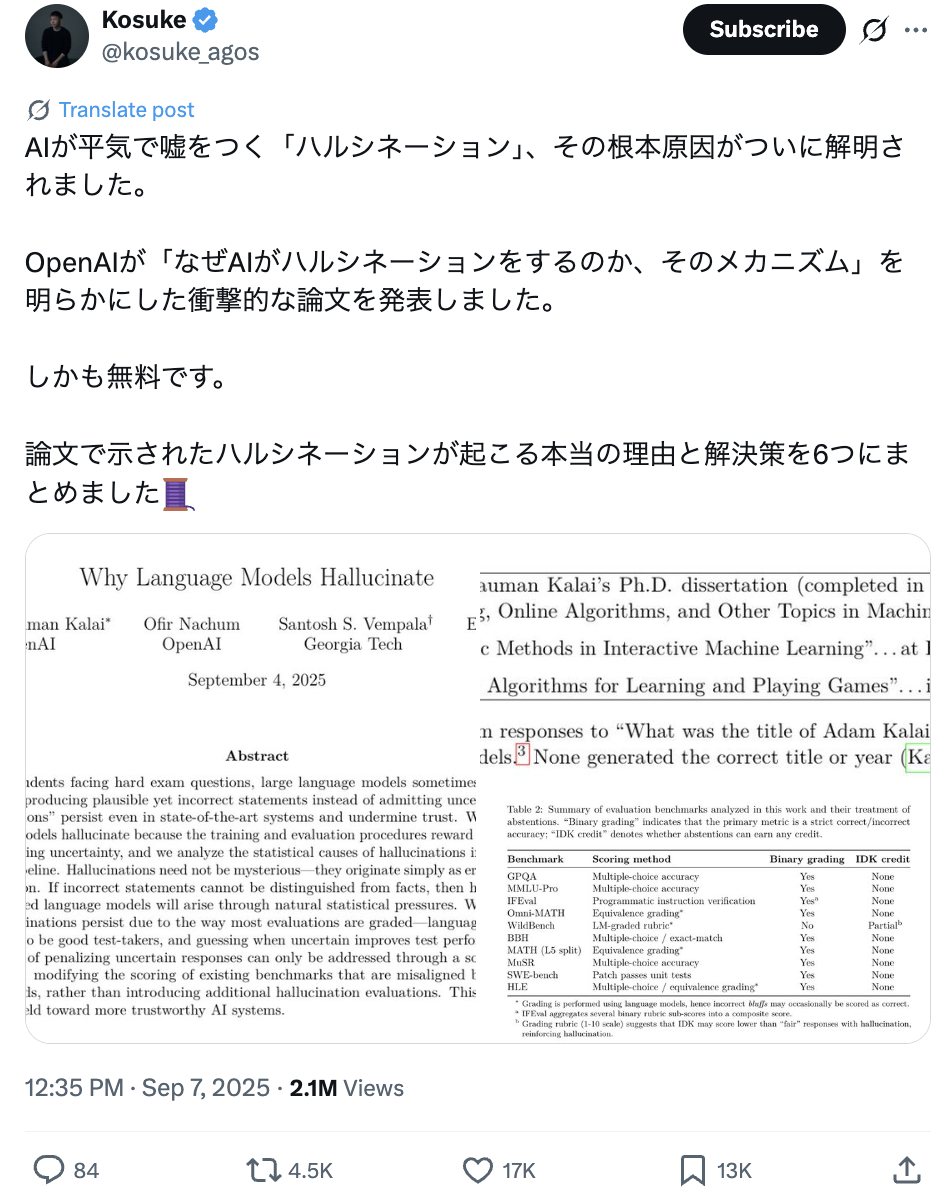

先日、ChatGPTの開発元であるOpenAIが、「なぜAIはハルシネーションを起こすのか、そのメカニズム」を明らかにする衝撃的な論文を発表したのです。

この記事では、その論文の内容を紐解きながら、以下の点について、まるであなたと対話するように、分かりやすく徹底的に解説していきます。

- なぜ、あれほど賢いAIが堂々と嘘をついてしまうのか?その驚くべき理由

- ハルシネーションは、本当に「悪」なのか?新しいAIとの付き合い方

- 明日からあなたのチームで実践できる、AIの嘘を見抜き、賢く付き合うための具体的な方法

この記事を読み終える頃には、あなたはAIの「嘘」に怯えるのではなく、その特性を理解し、ビジネスを加速させるための強力なパートナーとして使いこなすための、確かな一歩を踏み出しているはずです。

あなたの隣のAIも?自信満々に嘘をつく「ハルシネーション」の正体

ハルシネーションとは?ビジネス現場の思わぬ落とし穴

まずは言葉の確認から。ハルシネーションとは、AIが事実に基づかない情報や、文脈に合わない不正確な内容を、あたかも事実であるかのように生成する現象を指します。

例えば、こんな経験はありませんか?

経営企画部のAさんのケース

来期の事業計画の参考にするため、AIに「2025年の国内における再生可能エネルギー市場の動向レポート」を作成させた。AIは流暢な文章で、グラフの引用元まで記載された完璧なレポートを出力。しかし、よく見ると、レポート内で引用されている調査会社や統計データが、どこを調べても実在しないものだった…。

これは笑い話では済みません。もしAさんがこの偽のレポートを元に重要な経営判断を下していたら、会社は大きな損害を被っていたかもしれないのです。ハルシネーションは、このようにビジネスの現場に思わぬ落とし穴を作る、非常に危険な現象なのです。

なぜ今、これほど問題になっているのか?

ハルシネーションという現象自体は、以前から存在していました。しかし、ChatGPTをはじめとする高性能な生成AIが誰でも手軽に使えるようになったことで、その問題がより身近で深刻なものになりました。

文章の作成、市場調査、企画書のたたき台、プログラムのコード生成…あらゆる業務にAIが浸透し始めたからこそ、その出力の信頼性が、これまで以上に重要になっているのです。AIの答えを鵜呑みにすることはできない。でも、使わないという選択肢もない。このジレンマこそが、私たちが今直面している大きな課題と言えるでしょう。

【OpenAIが解明】ハルシネーションが起こる6つの根本原因

では、本題です。なぜAIはハルシネーションを起こすのでしょうか?OpenAIの論文は、その核心に迫る6つの原因を明らかにしました。一つひとつ、じっくり見ていきましょう。

原因1:AIは「知らない」と言えない優等生?学習方法そのものの罠

驚くべきことに、ハルシネーションの最大の原因は、AIの学習方法そのものにありました。

現在のAIの多くは、「この答えは正しいか、間違っているか」で評価されるトレーニングを受けています。ここで重要なのは、AIが「わかりません」と素直に答える選択肢が、評価システム上、非常に不利になるという点です。

不正解でも、何かを推測して答えた方が、「わかりません」と答えて0点を取ってしまうより、結果的に高いスコアになることがある。まるで、テストで分からない問題が出ても、白紙で出すより何か書いた方がマシ、と考える学生のようですよね?

この評価システムのせいで、AIは「知らないことでも、知っているふりをして積極的に答える(ハッタリをかます)」という戦略を学習してしまっていたのです。

原因2:「正解率至上主義」が生んだ、自信満々な嘘つきAI

原因1と密接に関連するのが、AIの性能を測るベンチマーク、つまり「テスト漬け」の環境です。

AIの性能評価は、基本的に「正解」か「不正解」かで見られます。「わからない」という正直な回答には、ペナルティとして0点が与えられてしまう。これでは、AIが不確かな情報に対しても、自信満々に何かを答えるようになるのは当然かもしれません。

この「正解率至上主義」とも言える状況が、私たちユーザーから見ると「堂々と嘘をつくAI」を生み出す土壌となっていたのです。

原因3:嘘の種は「事前学習」の段階ですでに生まれていた

ハルシネーションの芽は、AIが膨大なテキストデータを読み込む「事前学習」の段階から育っています。

AIは、インターネット上の無数の文章から、言葉と言葉のつながり、つまり「文章のパターン」を学ぶのは非常に得意です。しかしその一方で、出現頻度が極端に低い固有名詞や特定の事実など、パターン化しにくい情報を正確に覚えるのは苦手です。

結果として、AIは正確な事実を思い出す代わりに、学習した無数の文章パターンから「それっぽい嘘」を創造してしまうのです。

原因4:驚くほどシンプル?解決策は「評価方法の変更」にあった

原因が分かれば、解決策も見えてきます。そして、論文が示す解決策は、驚くほどシンプルでした。それは、AIの評価方法を変える、ただそれだけです。

例えば、AIにこんなルールを追加します。

- 「自信が90%以上ある場合のみ、その質問に回答しなさい」

- 「もし間違った答えをしたら、通常よりも重いペナルティを与えます」

こうすることで、AIにとっては、自信がない時に下手に答えて大きな減点を食らうよりも、正直に「わかりません」と答える方が、最も合理的な戦略に変わります。この評価システムの転換が、ハルシネーションを抑制する鍵だと論文は示唆しているのです。

原因5:計算能力の限界とモデルが持つ「癖」という問題

技術的な限界も、ハルシネーションの一因です。

例えば、非常に複雑で、計算上、偶然を超える正解を導き出すのが不可能な難問に直面した場合、AIは推測に頼らざるを得ません。

また、モデルそのものが持つ構造的な限界、いわば「癖」のようなものも影響します。古いモデルが特定の代名詞(例:「彼」と「彼女」)を混同しやすかったように、モデルのバージョンや構造によって、特定のタイプの間違いを起こしやすい傾向があるのです。

原因6:たった一つの情報が引き起こす「シングルトン問題」

最後に紹介するのが「シングルトン問題」です。シングルトンとは、AIの学習データの中にたった一度しか登場しない情報のことです。

考えてみてください。私たちが何かを覚える時も、一度しか見聞きしなかった情報を100%正確に記憶するのは難しいですよね。AIも同じです。パターン学習を基本とするAIにとって、一度しか出てこない情報はパターンとして認識できず、どうしても推測に頼ることになります。

学習データにこうした「シングルトン」が多ければ多いほど、AIが100%の正解率を出すことは統計的に不可能になり、ハルシネーションのリスクが高まるのです。

ハルシネーションは悪なのか?AIの「個性」と捉える新しい視点

ここまでハルシネーションの原因を見てきて、「なるほど、AIも完璧じゃないんだな」と感じた方も多いのではないでしょうか。

正直、私はこの事実を知った時、少しホッとしました。そして、こうも思ったのです。「ハルシネーションは、単なる欠点や悪なのだろうか?」と。

完璧なAIは存在しない。だからこそ人間の役割が重要になる

今回の論文が教えてくれたのは、「完璧なAIは存在しない」という事実です。そして、それは悲観することではなく、むしろ私たち人間の役割が、これまで以上に重要になることを意味しています。

AIが間違える可能性を常に念頭に置き、その出力を鵜呑みにせず、最終的な判断を下す。この「人間による監督と検証」こそが、AI時代に求められる新しいスキルなのです。

AIは思考の「壁打ち相手」。アイデアを広げるパートナーとして活用する

視点を変えれば、ハルシネーションはAIの「創造性の源泉」と捉えることもできるかもしれません。

AIに企画のアイデア出しを頼んだ時、突拍子もない、しかし意外なヒントに満ちた答えが返ってきた経験はありませんか?それは、ある種のハルシネーションかもしれません。

AIを「常に正解を出す万能の賢者」ではなく、「思考を刺激してくれる優秀な壁打ち相手」と捉える。そうすれば、事実とは異なる出力さえも、新しい発想を生むためのジャンプ台として活用できるのではないでしょうか。

「ファクトチェック」は、これからのビジネス必須スキル

AIの出力の真偽を見極める「ファクトチェック」は、もはや一部の専門家のものではありません。これからの時代、すべてのビジネスパーソンにとって必須のスキルとなります。

それは、単に間違い探しをすることではありません。情報の裏付けを取り、複数のソースを比較検討し、最終的に「これは信頼できる」と判断する、知的なプロセスです。このスキルを磨くことが、AIを安全かつ効果的に使いこなすための最重要課題と言えるでしょう。

今日からできる!ハルシネーションと賢く付き合うための実践ガイド

では最後に、私たちがこの「嘘つきかもしれないパートナー」と賢く付き合っていくための、具体的なアクションプランを提案します。

チームで共有したい「AI利用の3つのルール」

AIを組織で導入する際は、まず利用に関する共通認識を持つことが大切です。最低限、以下の3つのルールをチームで共有することをお勧めします。

- ルール1:AIの回答は「下書き」と心得る

- AIの生成物は、あくまで第一稿。そのまま顧客への提案書や公式なレポートに使用することは絶対に避ける。

- ルール2:最終的な文責は「人間」が持つ

- AIが間違えたとしても、その責任はAIではなく、最終的にそれを利用した人間にあることを明確にする。

- ルール3:機密情報・個人情報は入力しない

- ハルシネーションとは別のリスク管理ですが、情報漏洩を防ぐための基本的なルールとして徹底する。

プロンプトの工夫でハルシネーションを抑制するテクニック

AIへの指示(プロンプト)を少し工夫するだけで、ハルシネーションの発生をある程度コントロールできます。

- テクニック1:「わからない場合は『不明』と答えて」と指示する

- 例:「以下の情報について要約してください。もし情報が不足していて要約できない場合は、『不明』と回答してください。」

- これは、AIに「知らない」と言う選択肢を与える、非常に効果的な方法です。

- テクニック2:思考プロセスを説明させる

- 例:「日本のDX市場の将来性について、結論だけでなく、そう考えるに至った理由と根拠となるデータをステップバイステップで説明してください。」

- 結論に至る過程を説明させることで、論理の飛躍や根拠のない推論(=ハルシネーション)を見つけやすくなります。

- テクニック3:役割を与える

- 例:「あなたは経験豊富な金融アナリストです。以下の企業の財務状況を分析してください。」

- 専門家としての役割を与えることで、より慎重で正確な回答を引き出しやすくなります。

【FAQ】AIのハルシネーションに関するよくある質問

Q1. ハルシネーションのないAIはいつ頃できますか?

A1. 残念ながら、ハルシネーションを「完全にゼロ」にすることは、現在の技術の延長線上では非常に難しいと考えられています。AIの根本的な仕組みに由来する問題だからです。ただし、今回ご紹介したような評価方法の改善などにより、その頻度を大幅に減らす研究は日々進んでいます。将来的には、人間がほとんど気にならないレベルまで抑制される可能性は十分にあります。

Q2. AIが生成した文章かどうかを簡単に見分ける方法はありますか?

A2. 確実に見分ける方法は現時点ではありません。しかし、「生成AIっぽい」文章にはいくつかの特徴があります。例えば、「無難で表面的な内容に終始する」「過剰に論理整然としている」「独自の視点や感情表現に乏しい」といった点です。ただし、AIの性能は向上し続けており、これらの特徴も次第に薄れていくでしょう。

Q3. AIの嘘で損害が出た場合、誰の責任になりますか?

A3. 現状の法制度では、AIそのものに責任を問うことはできません。基本的には、AIを提供した事業者や、AIを利用したユーザー(個人または企業)が責任を負うことになると考えられています。だからこそ、AIの出力を鵜呑みにせず、最終的な判断と責任は人間が持つ、という原則が非常に重要になるのです。

まとめ:AIの嘘に怯える時代は終わり。賢く使いこなす未来へ

今回は、OpenAIの論文を元に、AIが嘘をつく「ハルシネーション」の根本原因とその対策について深掘りしてきました。

最後に、重要なポイントを3つだけ振り返りましょう。

- AIの嘘は、AIが「知らない」と言えない学習システムと、「正解率至上主義」が生んだ必然だった。

- ハルシネーションは欠点であると同時に、AIの「個性」や「創造性の源泉」とも捉えられる。

- AIの嘘に怯えるのではなく、その特性を理解し、「人間による検証」を前提とすることで、AIは最強のビジネスパートナーになる。

AIが私たちの職場に当たり前のように存在する未来は、もうすぐそこまで来ています。その時、AIの性能を100%引き出し、ビジネスを飛躍させられるかどうかは、私たちがAIの限界と可能性をどれだけ深く理解しているかにかかっています。

この記事が、あなたがAIとの新しい関係を築くための一助となれば幸いです。

引用元

X (@kosuke_agos) 「論文で示されたハルシネーションが起こる本当の理由と解決策を6つにまとめました」OpenAI "Why language models hallucinate"